La caratteristica più nota e pubblicizzata delle fotocamere digitali è in numero di megapixel. All’aumentare di questo aumenta la risoluzione della fotocamera e addirittura molti pensano che questo sia l’unico indice di qualità di una digitale. Attualmente il numero di megapixel raggiunge il valore di 12 anche per le compatte, mentre le reflex fullframe arrivano a 24. Sembrerebbe quindi che le fotocamere digitali abbiano raggiunto una risoluzione sufficientemente alta per competere e forse superare quelle a pellicola e adeguata alle attuali esigenze dei fotografi-

La caratteristica più nota e pubblicizzata delle fotocamere digitali è in numero di megapixel. All’aumentare di questo aumenta la risoluzione della fotocamera e addirittura molti pensano che questo sia l’unico indice di qualità di una digitale. Attualmente il numero di megapixel raggiunge il valore di 12 anche per le compatte, mentre le reflex fullframe arrivano a 24. Sembrerebbe quindi che le fotocamere digitali abbiano raggiunto una risoluzione sufficientemente alta per competere e forse superare quelle a pellicola e adeguata alle attuali esigenze dei fotografi-

Ma la risoluzione dichiarata e tanto pubblicizzata dai produttori è vera o c’è qualcosa dietro che non ci vogliono dire?

La maggior parte dei sensori usati sulle attuali fotocamere digitali è del tipo CCD o CMOS con tecnologia Bayer, dal nome dello scienziato Bryce Bayer della Kodak che la inventò nel 1976.

Un sensore ditipo bayer è composto da tante cellette (pixel), di norma quadrate, sensibili alla luce. Questi sensori però non distinguono i colori, sono solo in grado di emettere un segnale elettrico, proporzionale alla quantità di luce (di fotoni) raccolta fino alla saturazione.

Come è possibile allora distinguere i colori? E quali colori innanzitutto?

Come nella fotografia a pellicola (chimica), nei monitor dei computer e nelle televisioni i colori necessari per riprodurre una qualsiasi immagine possono essere ridotti a tre, i cosiddetti colori primari, rosso, verde e blù (RGB). Combinando opportunamente luci di questi tre colori è possibile riprodurre qualsiasi sfumatura di colore.

I pixel contenuti nel sensore però sono sensibili solo alla quantità di luce, ma non distinguono i colori. Quindi ci danno solo un’informazione quantitativa sulla luce che ricevono, ma non sul suo colore. Per poter avere anche l’informazione sul colore nei sensori di tipo Bayer si antepone a ciascun pixel un filtro colorato, rosso, verde o blu, che lascerà passare solo la luce di quel colore.

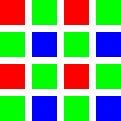

In questo modo i pixel col filtro rosso daranno informazioni sulla luce rossa ,verde e blu. I pixel sono distribuiti sul sensore secondo lo schema in figura.

Il 25 % dei pixel sono sensibili al rosso, il 25 % al blù e il 50 % al verde. Questo perchè l’occhio è più sensibile al verde che richiede quindi maggior precisione. Quindi su una riga si alternano un pixel rosso ed uno verde, mentre sulla successiva uno verde ed uno blu e così di seguito. La risoluzione del sensore è in queste consizioni il 25 % dei pixel dichiarati per il rosso ed il blù ed il 50 % per il verde: molto meno di quanto ci si aspetterebbe. In questo modo inoltre l’informazione colore è solo parziale: come è possibile ricostruire l’informazione di colore dove manca, in modo di avere per ogni pixel l’informazione sui tre colori primari e riprodurre così i colori originali dell’immagine?

Questa operazione è effettuata tramite un algoritmo di interpolazione. In pratica il software nella fotocamera, oppure quello sul pc del convertitore raw ricostruisce l’informazione di colore per ciascun pixel derivandola da quella dei pixel adiacenti. In questo modo si potrebbe, considerando i pixel a gruppi di quattro, ricostruire per ciascun gruppo un pixel con l’informazione colore completa (vedi figura).

Con questo algoritmo però si dimezzerebbe la risoluzione orizzontale e quella verticale ed il numero totale dei pixel dell’immagine sarebbe solo un quarto di quelli del sensore.

Ci sono però degli algoritmi che considerando i pixel adiacenti a ciascun gruppo di quattro riescono a ricostruire ulteriori pixel con informazioni complete. si può arrivare a valori del 70-80 % della risoluzione nominale Così è possibile aumentare la risoluzione effettiva del sensore.

Naturalmente il file di output jpeg conterrà tutti i pixel dichiarati, quelli che mancano saranno ulteriormente interpolati da quelli ricostruiti con le informazioni del sensore non aggiungendo quindi nessuna nuova informazione nell’immagine.

Di seguito un crop di una foto come vista dal sensore di una fotocamera digitale prima dell’interpolazione e demosaicizzazione Bayer.

Oltre a questa tecnica necessaria per la riproduzione dei colori c’è un altro fattore che limita la risoluzione dei sensori: il filtro antialias. I sensori, come tutti i sistemi di campionamento digitale, possono riprodurre un’informazione che vari con una frequenza inferiore o uguale alla metà della frequenza con la quale rilevano l’informazione (frequenza di Nyquist). Cosa vuol dire questo discorso un po’ complicato e contorto (è semplice e comprensibile esprimerlo con formule matematiche) nel campo della fotografia? Se ho un sensore con, ad esempio, 4000 pixel in orizzontale e 3000 in verticale (12 Mpx), questo potra risolvere al massimo 2000 linee in orizzontale e 1500 in verticale. Il numero di righe per unità di lunghezza si definisce la loro frequenza. Se si tenta di riprodurre una frequenza maggiore, cioè un numero di righe maggiore di 2000 in orizzontale, il sensore non è in grado di farlo, anzi le informazioni che restituisce saranno sbagliate dal punto di vista risoluzione e colore con la produzione di righe ed artefatti multicolori (effetto moirè). nei sensori Bayer in particolare questo fenomeno è molto accentuato perchè la risoluzione dei colori rosso e blu è solo il 25 % di quella dichiarata e del verde il 50%. Per evitare ciò davanti al sensore viene posto un filtro che riduce la risolvenza in modo da evitare l’effetto moirè. Questo filtro ovviamente non può tagliare completamente le frequesze al di là delle quali l’effetto si verifica (frequenza di Nyquist), altrimenti ridurrebbe troppo la risolvenza anche per quelle inferiori. I produttori cercano dunque un compromesso che limiti l’effetto moirè senza penalizzare troppo la risolvenza, che risulta comunque inferiore a quella teoricamente possibile.

la risoluzione effettiva di un sensore in funzione del numero dei pixel è espressa dalle curve in figura.

L’unico sensore che non funziona secondo questi principi è il sensore Foveon, utilizzato dalle fotocamere Sigma. Questo sensore è composto da tre strati sovrapposti sensibili rispettivamente al blu, al verde ed al rosso. Ogni pixel quindi è sensibile ai tre colori e restituisce un’informazione completa.

La risoluzione del sensore è quindi pari a quella nominale. Inoltre visto che ogni pixel può ricevere i tre colori è possibile eliminare il filtro antialias non limitando in alcun modo la risoluzione del sensore. L’effetto moirè, che può essere presente anche se in forma molto più ridotta che sui sensori Bayer, viene controllato via software.

I sensoi Foveon hanno una risoluzione nominale più ridotta dei Bayer: attuaòmente l’ultima versione montata sulle Sigma SD15 reflex e DP2 compatta è di 4,7 Mpx contro una risoluzione media di 12 Mpx per i Bayer, anche se Sigma la pubblicizza come una 14,1 Mpx. In realtà è vero che ha, a rigore, 14 Mpx, però i pixel sono sovrapposti a tre a tre per cui l’immagine di output risulta di 4,7 Mpx.

La risoluzione del sensore Foveon è però effettiva e non subisce diminuzioni dovute all’interpolazione come quella dei Bayer e può essere paragonata a quella di un Bayer da almeno 8 Mpx. Un sensore Bayer da 12 Mpx ha invece una risoluzione effettiva di circa 8 Mpx.

Per verificare l’influenza della demoicizzazione Bayer sulla risoluzione. Ho utilizzato una foto che ho scattato in una breve prova della Sigma DP1 con sensore Foveon da 4,7 Mpx. Ho usato foto scattate con il sensore Foveon perchè queste per essere trasformate in un formato visibile non sono sottoposte alla demoicizzazione. Per simulare l’effetto del sensore Bayer ho utilizzato un filtro, plug-in di Photoshop, che elimina dai pixel alternativamente i colori per trasformare le foto secondo lo schema Bayer e poi un secondo filtro che applica l’interpolazione per riportare la foto ai colori originali. I filtri sono stati utilizzati tramite IrfanView, un programma di fotoritocco gratuito molto interessante di cui parlerò in futuro.

Ho applicato la demicizzazione bayer anche ad una foto scattata con un sensore Bayer e ne ho scelta una ad elevata risoluzione (21 Mpx) fatta con una Canon 1Ds III.

I risultati si possono vedere nei crop al 100 % presentati.

Ho pubblicato poi i crop di altre foto di esempio dal sito di Imaging Resource, con la Sigma DP1 e di DPReview con la Sigma DP1 e la SD10 reflex, tutte con sensore Foveon da 4,7 Mpx

Come si può vedere le foto originali Sigma perdono tutte risoluzione e dettaglio e risultano più “impastate”. In particolare si possono notare nella foto con le scritte, che sono al limite della risoluzione del sensore, le alterazione di colore delle scritte dovute all’interpolazione a partire dal 25 o 50 % dei colori originali.

Nei crop al 200 % di quest’ultima foto si notano in particolare nelle scritte le alterazioni di colore dovute all’interpolazione Bayer.

In conclusione la risoluzione reale dei sensori digitali, CCD o CMOS, che funzionano secondo lo schema Bayer è inferiore a quella dichiarata e a quella che si aspettano i fotografi e non superiore al 70 % del valore nominale. I sensori Foveon, pur avendo invece una risoluzione inferiore non soffrono di questo problema in quanto la loro immagine non necessita di demosaicizzazione ed interpolazione e la loro risoluzione è quella dichiarata. Anche l’assenza del filtro antialias contribuisce alla sua maggior sensazione di nitidezza. Inoltre la sua resa dei colori è molto più naturale

Perchè allora il sensore Foveon non è adottato da tutti i produttori? Prima di tutto anche questo sensore ha i suoi problemi che sono essenzialmente la scarsa sensibilità ed il rumore alle alte sensibilità, che si traduce in una alterazione ed una diminuzione di intensità dei colori. Poi la ragione principale è che tutti i più grandi produttori di sensori, Canon e Sony prima di tutti, hanno fatto grandi investimenti nei sensori CCD e CMOS di tipo Bayer e non hanno certo l’intenzione di buttarli via per investire in una nuova tecnologia di sviluppo incerto e di cui il grande pubblico non sente la necessità perchè soddisfatto da ciò che attualmente gli viene offerto.

impressionante! se le sigma fossero un tantino più affidabili ed avessero (dp1 e dp2) uno stabilizzatore d’immagine, non ci sarebbe gioco per nessuno.

"Mi piace"Piace a 1 persona

Spiegazione di livello quasi universitario che penso soddisfi la maggior parte di quelli che come me desiderano vedere dentro la moderna tecnologia. Grazie

"Mi piace""Mi piace"

Superlativo!! Semplicemente superlatico!! Grazie.

Lori.

"Mi piace""Mi piace"

Come già è stato detto, degno di un articolo accademico!!!

Ottima spiegazione!!! Grazie.

Avevo già notato i concetti espressi nel tuo articolo (anche se non analizzati nel dettaglio come te) e i sensori Foveon sono sicuramente molto interessanti. Peccato che i concorrenti usino risoluzioni talmente alte da renderne inutili i teorici vantaggi. E probabilmente i prezzi sono comparabili.

Dico questo solo per spiegare che quando demosaicizzi una foto scattata con un sensore Foveon, in realtà è come se considerassi una foto con un sensore Bayer di 4,7 Mpx, ma i concorrenti usano sensori di 12 Mpx!!!

Grazie ancora per come ci trasmetti la tua passione!

"Mi piace""Mi piace"

Grazie a voi tutti

Francesco

"Mi piace""Mi piace"

Molto interessante!

Mi propongo di rileggerlo perchè, anche se sono laureato in Fisica(e nucleare), sono novizio nella Fotografia e molti concetti e definizioni mi sono nuovi.

Complimenti vivissimi per la conoscenza e per l’esposizione.

"Mi piace""Mi piace"

Grazie Mario.

Francesco

"Mi piace""Mi piace"

Mi associo anch’io ai complimenti per la chiarezza con la quale sono trattati questi argomenti tecnici.

Sono un fotografo professionista, e lei Franceso, comprenderà quanto sia fondamentale per me conoscere esattamente le potenzialità ed i limiti delle attrezzature di cui posso disporre. Quando si usava la pellicola era tutto più chiaro, oggi i dubbi sono tanti e soprattutto non si conosce chi possa rispondere a certe domande e a certi quesiti che via via ci si pone.

Non voglio approfittare della sua cortesia pertanto, le pongo una sola questione.

Se i sensori Bayer hanno in definitiva una risoluzione pari al 70% di quella nominale, mi chiedo: ciò riguarda qualunque prodotto indistintamente (Nikon, Canon, Phase one, Ixpres) o varia a seconda del produttore? Lei comprenderà che se la perdita è uguale per tutti, questo valore nominale continua ad avere un senso, altrimenti risulta del tutto inutile.

E ancora, usando la stessa attrezzatura in tutte le tipologie di foto che realizzo ho solo quel 70% di risoluzione o questa percentuale varia a seconda di certe condizioni di lavoro: in studio con luci lampo, piuttosto che con luce naturale, con tempi brevi piuttosto che lunghi, alla sensibilità iso nominale o a quelle più elevate ecc.?

E Infine, le regolazioni che io posso impostare sulla mia camera, es. D-light attivo o maschera di contrasto, o riduzione disturbo, hanno influenza sulla famosa percentuale?

Confido sulla sua risposta che sarà senz’altro esauriente e le porgo i più cordiali saluti

antonio cozza

"Mi piace""Mi piace"

Antonio, come ho già spiegato la risoluzione ottenibile da un sensore Bayer dipende dalla capacità dei programmi di interpolazione che trasformano il formato raw in un tiff o jpeg visibile. Il funzionamento dei sensori Bayer è lo stesso per tutti i produttori, ma il software di interpolazione può variare da uno all’altro e quello in funzione sulla fotocamera, se si salvano le immagini direttamente in jpeg, è sicuramente diverso da quello che si può usare sul pc per convertire i raw. Questo può essere sicuramente più complesso ed eseguire un’elaborazione più accurata e più pesante perchè non deve convertire la foto in pochi istanti, ma può impiegare anche minuti. Questo spiega perchè per ottenere la migliore qualità è opportuno salvare le foto in raw e convertirle a posteriori in jpeg.

La percentuale del 70 % è solo indicativa e varia a seconda del produttore, del livello di tecnologia (le fotocamere odierne hanno routine di conversione migliori di quelle del passato) ed anche a secondo di ciò che si fotografa, dei dettagli fini presenti e dell’illuminazione. Per questo è importante vedere un test sul campo delle fotocamere e ciò spiega spesso le differenze fra l’una e l’altra.

Le regolazioni o le correzioni apportate a posteriori, dopo la conversione raw-jpeg come d-light, maschera di contraso, riduzione di rumore, non hanno alcuna influenza sulla risoluzione ottenibile durante la conversione.

Ciao e auguri,

Francesco

"Mi piace""Mi piace"

Che cosa succederà con l’avvento p.v. (forse il prossimo anno) dei sensori a punti quantici?

Non sarà che dovremo buttare (letteralmente)tutte le attuali reflex!?

Saluti.

Giampiero

"Mi piace""Mi piace"

Giampiero, io credo che la tecnologia dei sensori a punti quantici sia di la da venire se mai sorà veramente sviluppata.

La InVisage è una piccola società, ma i grandi produttori di sensori sono altri e difficilmente butteranno a mare i loro investimenti per una tecnologia nuova, sconosciuta e dai dubbi risultati. La InVisage promette un guadagno di sensibilità di 4x rispetto ai sensori tradizionali, ma basta guardare gli schemi proposti sul suo sito per capire che metà di questo vantaggio è stato perso con i sensori retroilluminati.

Molte volte piccole società fanno annunci mirabolanti per farsi pubblicità, ma non è detto che poi queste cose abbiano seguito.

Non c’è riuscito nemmeno il sensore Foveon che ha dei vantaggi tangibili rispetto ai tradizionali Bayer.

Quindi non ti preoccupare non dovrai buttare vie le tue reflex.

Ciao, Francesco

"Mi piace""Mi piace"

Grazie Francesco,

sono un po’ più tranquillo, anche perché sto “buttando” Contax, “saltando” la compatta, per una reflex digitale… ora sto valutando moooolto attentamente “quale”.

((( Certo, però il sospetto che i “giganti” possano ancora prevalere dettando legge nell’ hi-tech come sulle energie alternative, resta, ma è una vecchia storia che intanto ci “rassicura”.)))))

Grazie comunque e di nuovo, cordialissimi saluti ciao,

Giampiero

"Mi piace""Mi piace"

Ciao, sono capitato per caso in questo sito cercando notizie della nuova nikon. Che bello! i miei entusiasti complimenti. Sto divorando tutti gli articoli, da quelli tecnici alle recensioni. Capisco poco di frequenze, ma avrei una domanda, dici che se un sensore ha 4000 pixel in orizzontale e, per la storia delle frequenze, può risolverne il 50 % dovrebbe significare che può disegnare 2000 linee in verticale, se ha 3000 pixel in verticale dovrebbe risolvere 1500 linee in orizzontale, o no ? dov’è che non capisco?

Grazie infinite per tutte le informazioni.

renzo

p.s. ho ancora una vecchia Nikon 8008 (sigla americana), attulmente solo con una compatta panasonic dmc tz5 molto carina, ma aspetto un’ulteriore tua prova della nuova d7000, forse mi farò un bel regalo a natale, grazie.

"Mi piace""Mi piace"

Renzo, un sensore da 4000×3000 pixel potrebbe, in teoria risolvere 2000 linee in verticale e 1500 in orizzontale. Però per riprodurre i colori ogni pixel ha davanti un filtro colorato che fa si che capti solo la luce di quel colore. I filtri sono per il 50 % verdi (dove l’occhio umano è più sensibile) per il 25 % rossi e per il 25 % blu. Questo vuol dire che la risoluzione è al massimo 2000:2=1000 e 1500:2=750 linee per il verde e 2000:4=500 e 1500:4=375 per il rosso e blu. Con gli algoritmi software di interpolazione necessari per ricostruire l’informazione sui colori mancanti per ciasun pixel si può raggingere il 50 % della risoluzione nominale o anche di più, fino al 60-65 %, ma mai il 100 %.

Ciao, Francesco

"Mi piace"Piace a 1 persona

Grazie, molto chiaro. Continuerò a leggere le tue recensioni. ciao.

"Mi piace""Mi piace"

Bravo Francesco!

Sono capitato proprio stamattina sul tuo sito e l’ho già inserito tra i preferiti!!!

I complimenti sono d’obbligo!!!

A proposito di questa recensione, considerando poi che è di più di un anno fa, non posso che ripetermi per i complimenti, data la lucida e capace analisi!

Sono un profondo sostenitore del Foveon da anni, quando discutendo con un mio caro amico, professore universitario, nonchè uno dei massimi esperti di colorimetria a livello nazionale e non solo, si valutavano i possibili vantaggi rispetto ai CCD e CMOS. Il punto è che il brevetto di tale sensore è in mano a Sigma (o per lo meno lo era fino a poco tempo fa) che non ha certo la capacità di ricerca e sviluppo di ben più note case giapponesi!

Ora sembra che Panasonic, Canon e Nikon ci stiano lavorando, ma per i tempi, non si intravede ancora nessun dato! Quindi per non restare ad aspettare mesi o anni, ho pensato bene di dare respiro alla mia sfruttatissima Canon 5D (acquistata appena uscita in Italia ottobre 2005) con una nuova 5D MkII. Non mi posso lamentare della qualità, ma il Foveon……. resta il mio sogno!!!

Sono curioso di leggere altro sulla Sigma SD1 se riuscirai a provarla bene!

Una sola osservazione: nelle comparazioni tra macchine diverse, sarebbe bello vederle nelle stesse condizioni per poterle meglio valutare! Capisco che non sia sempre facile e comunque apprezzo tantissimo il lavoro importante e serio che fai per il nostro mondo!!!!!!!

"Mi piace""Mi piace"

Nic hai qualche informazione sull’interesse di altri produttori oltre Sigma al Foveon? Sigma è una piccola casa e il suo “core business” sono gli obiettivi quindi purtroppo è molto lenta nello sviluppo di questo sensore dalle ottime qualità, ma anche con difetti che dovrebbero essere eliminati. Speriamo che lo facciano presto!

Per provare la SD1 credo che si dovrà attendere se i suoi tempi di sviluppo saranno come quelli del passato, tipo la SD15 presentata come prototipo in Photokina 2008 e disponibile solo a metà 2010.

Infine piacerebbe anche a me poter fare le prove sempre con gli stessi soggetti, ma questo è possibile solo con le macchine che mi vengono affidate in prova o eventualmente prestate da amici. Presto ne pubblicherò una della Olympus E-PL1. Quando si provano nelle mostre o nelle manifestazioni dei produttori si deve fotografare quello che è disponibile.

Ciao, Francesco

"Mi piace""Mi piace"

ho letto in rete qualcosa su prossimi possibili brevetti di case più dedite alla costruzione di sensori sul Foveon. Spero non siano solo voci, ma mi riservo di controllare, anche per verificare che il brevetto originale sia sempre in mano solo a Sigma, costringendo le altre case a lavorare su alternative progettuali!

se scopro qualcosa, ti dico! se trovi qualcosa prima tu, posta!

grazie Francesco, nic

"Mi piace""Mi piace"

http://www.fotozona.it/magazine/panasonic-come-sigma-brevetta-cmos-multistrato-2730

e dalle voci che si leggono, forse anche sony potrebbe essere al lavoro e un domani fornirle a nikon come già fa per alcune macchine

"Mi piace""Mi piace"

http://www.clickblog.it/post/759/brevetto-nikon-per-un-sensore-full-color-rgb

forse nikon è più avanti di sony, ma dubito!

"Mi piace""Mi piace"

panasonic non tarderà:

http://www.43rumors.com/panasonic-3-layer-patent-like-the-sigma-foveon-sensor/

da canon non trapela niente, ma non penso sia al palo!

"Mi piace""Mi piace"

Molto, molto, molto interessante questo post.

Tecnicamente complesso ma comprensibile (almeno nel “succo” del discorso).

Ancora una volta grazie Francesco. 😀

Mario

"Mi piace""Mi piace"

Francesco ma con quale software riesci a visualizzare il raw non demosaiccizzato?

"Mi piace""Mi piace"

Marco,

non visualizzo il raw non demoisaicizzato.

Ho usato due plug-in di Photoshop, bayerize.8bf e debayerize1.8bf per “bayerizzare” un jpeg e poi demosaicizzarlo.

Sono plug-in molto vecchi e non è detto che funzionino con Photoshop CS6. Io li avevo usati con Gimp 2 usando un plug-in chiamato PSPI che consentiva di caricarli, ma attualmente, dopo aver cambiato sistema operativo con Windows 7 e versione di Gimp con la 2.8 non mi funzionano più.

Ciao, Francesco

"Mi piace""Mi piace"

Grazie!

"Mi piace""Mi piace"

Grazie, finalmente una spiegazione chiara e scientifica, visto che su altri siti dichiarano quasi sempre la risoluzione di un sensore foveon un terzo di quella dei cmos o ccd!! Quindi la risoluzione effettiva di questi ultimi è virtualmente ricostruita dal firmware, altrimenti quella effettiva legata al fotosito fisico sarebbe ridotta di un quarto o più.

Marco.

"Mi piace""Mi piace"

Salve

articolo veramente esaustivo! complimenti.

Le chiedo:

le nuove reflex con sistema dualpixel (che se ho capito bene) servono solo per la messa a fuoco? la risoluzione è la metà? (anzi il 70% della matà?).

Poi: questa tecnologia serve solo per i filmati e live view?

E vero che non è utilizzabile con aperture grandi sotto f5,6?

Grazie mille.

sangiorgio

"Mi piace""Mi piace"

Luciano,

nelle reflex Canon con sensori con tecnologia Dual Pixel AF i pixel sono sdoppiati (nei Canon l’80 % è sdoppiato) per potere effettuare la messa a fuoco a rilevamento di fase. Lo sdoppiamento vale però solo ai fini della messa a fuoco mentre per la formazione dell’immagine il pixel funziona come una singola unità. Quindi il sensore della EOS 70D o 7D Mk II ha ai fini dell’immagine 20 Mpx, mentre ai fini della messa a fuoco ha l’80 % dei pixel sdoppiati. Anche questi però sono sensori con tecnologia Bayer quindi la loro effettiva risoluzione è stimabile nel 60-70 % di quella nominale.

Non mi risulta che la messa a fuoco a rilevamento di fase attuata dai pixel sdoppiati non sia utilizzabile con aperture più ampie di f/5,6, anzi semmai dovrebbe essere il contrario. Più è aperto il diaframma più luce arriva dalle zone periferiche dell’obiettivo e quindi la mossa a fuoco a rilevamento di fase è più efficiente. Semmai il limite è dato dalla quantità di luce complessiva che arriva al sensore. Se è troppo poca la messa a fuoco a rilevamento di fase potrebbe non funzionare. Questo porta a concludere che con un obiettivo di alta luminosità, f/1,4 ad esempio, la messa a fuoco a rilevamento di fase sul sensore potrebbe funzionare in condizioni di luce inferiori a quelle a cui potrebbe farlo con un obiettivo f/5,6.

Ciao, Francesco

"Mi piace""Mi piace"

Grazie mille.

Non riuscivo a capire come funzionava lo sdoppiamento.

Spero ci farai sapere presto come sarà la nuova Canon pro di cui si parla che -si dice- dovrebbe avere novità importanti.

grazie ancora

Luciano

"Mi piace""Mi piace"

Salve

Vorrei sapere se il sensore della pentax 645Z crea problemi per ottenere immagini nitide come sembra avvenga con la Canon 5Ds a causa dei micromovimenti dello specchio. Oppure questo è un problema solo se i 50 MPIXEL sono “stipati” dentro un sensore full-frame?

Ultima domanda: ho letto che la pentax 645F ha il sincro flash a 1: 125.

dipende dalla macchina o dagli obiettivi? Se dipende dagli obiettivi è possibile montare obbiettivi non pentax?

Grazie

luciano

"Mi piace""Mi piace"

Luciano,

da quando sono state introdotte, tempo fa, le fotocamere reflex è noto che il ribaltamento dello specchio produce vibrazioni che possono influire negativamente sulla nitidezza dell’immagine se si scatta con tempi lunghi. Infatti questo è sempre stato un argomento a favore delle Leica a telemetro contro le reflex. Le reflex professionali, e anche qualche amatoriale, per questo avevano a suo tempo la possibilità di ribaltare lo specchio manualmente prima dello scatto (ovviamente scattando su treppiede e predisponendo in precedenza l’inquadratura) per evitare questo fenomeno. Questa possibilità è poi stata abbandonata nelle attuali reflex digitali.

C’è da considerare che anche l’apertura della prima tendina dell’otturatore può causare vibrazioni. Infatti alcune fotocamere digitali dispongono della funzione di otturatore elettronico, cioè invece di fare aprire la prima tendina iniziano l’esposizione elettronicamente terminandola poi con la chiusura della seconda tendina, Un esempio è la Sony A7.

La Canon 5DS non ha questa possibilità, ma può ritardare lo scatto di un intervallo variabile dopo il sollevamento dello specchio per ridurre le vibrazioni. La Pentax 645Z non ha questa possibilità (almeno non se ne parla nelle specifiche).

In ogni caso c’è da considerare che più è alta è la risoluzione più il fenomeno può diventare visibile, ma questo comunque è sempre presente, solo che un sensore con meno risoluzione lo vede di meno perchè non distingue i dettagli più fini. In pratica la sua immagine è comunque meno nitida di uno con più risoluzione. La Pentax 645Z ha 8256 pixel in orizzontale su 43,8 mm quindi 188 pixel per mm, la Canon 5DS 8688 su 36 mm quindi 241 pixel per mm per cui dovrebbe risentire un po’ di più delle vibrazioni, ma ripeto la diminuzione di nitidezza può essere visibile con le risoluzioni di questi sensori perchè sono molto elevate mentre non sono visibili con sensori con un numero di pixel inferiore perchè questi sono in partenza meno nitidi. Se poi consideriamo i sensori APS con 24 Mpx come quello della 760D che ha 6000 pixel su 22,3 mm con 269 pixel per mm, o quelli analoghi di Nikon e di Sony, questi dovrebbero risentire ancora di più dei movimenti di specchio e tendina.

Concludo quindi che non è un problema nuovo e che Canon ha voluto inserire alcune funzioni per minimizzarlo perchè questa fotocamera è dedicata a chi ha bisogno di fare forti ingrandimenti e di lavorare con la macchina su treppiedi cercando la massima nitidezza e scattando alla minima sensibilità quindi spesso con tempi lenti.

La Pentax 645Z dispone di otturatore a tendina sul piano focale e non di otturatore centrale negli obiettivi come le Hasselblad C. La sua velocità di sincronizzazione flash è determinata, come per tutte le fotocamere con otturatore a tendina, dal tempo impiegato dalla seconda tendina per coprire la distanza necessaria a ricoprire il sensore. Quando il tempo di scatto è lento la seconda tendina parte quando il sensore è già stato completamente scoperto dalla prima, quando è veloce (inferiore al tempo che impiega la tendina per fare il percorso corrispondente alla dimensione del sensore) la seconda parte quando la prima non ha completamente scoperto il sensore. Il flash deve scattare quando il sensore è completamente scoperto per potere consentire di riprendere tutta l’inquadratura in quanto la sua durata è molto più breve dei tempi di scatto (va da 1/1000 a 1/40000 e più), quindi la sincronizzazione deve avvenire con il tempo minimo durante il quale il sensore è completamente scoperto. Più questo è grande più tempo ci vuole alle tendine per scoprirlo o coprirlo completamente e quindi il tempo di sincronizzazione è più lento. Questo dipende ovviamente dalla velocità delle tendine che però non può essere aumentata più di tanto. In conclusione la 645Z ha un tempo di sincronizzazione flash inferire ad una reflex fullframe o APS per il suo sensore più grande.

Per quanto ti ho detto è impossibile modificarlo montandovi altri obiettivi.

Ciao, Francesco

"Mi piace""Mi piace"

Grazie ancora.

sto pensando di comprarla la pentax ma del medio formato non ci capisco un cavolo!

tra l’altro sembrerebbe più indicata in studio che per foto di strada. Bene invece architettura e paesaggi.

Grazie ancora

Luciano

"Mi piace""Mi piace"

Luciano,

la Pentax 645Z è adattissima per foto in studio, ma anche per paesaggi, monumenti, ritratti, eventi e cerimonie. Infatti non è più pesante di reflex come Canon 1Dx e Nikon D4s e il suo autofocus è veloce e reattivo. Oltretutto arriva ad una sensibilità di 204800 Iso e la qualità d’immagine fino a 12800 Iso è ottima. Non mi sembra invece molto adatta ale foto di strada per le sue dimensioni, peso e vistosità, ma nessuno vieta di usarla anche per questo.

Ciao, Francesco

"Mi piace""Mi piace"

Ciao Francesco. Ho letto con interesse il tuo “saggio” sulla risoluzione dei sensori ed ho deciso di effettuare un piccolo test. Con la mia Fuji HS50EXR (quindi sensore piccolo) ho scattato una foto salvandola in JPG a 16 Mp. Quindi l’ho stampata in formato A3. Poi ho dimezzato la foto a 8 Mp e l’ho ristampata sempre in A3. Infine ho ulteriormente dimezzato la foto a 4 Mp e l’ho ristampata sempre in A3. Ebbene, dal confronto tra le stampe francamente non vedo differenze apprezzabili ad occhio nudo. Forse qualcosina si noterebbe tra la prima e la terza ma è molto impercettibile. Concludo quindi che per le fotocamere aventi sensore piccolo il maggior dettaglio che sarebbe osservabile a 16 Mp è praticamente solo virtuale e che salvare in JPG a 16 Mp è praticamente inutile. Infatti di solito io salvo a 8 Mp. Ma forse andrebbero bene, per un uso “standard”, anche i 4 Mp.

"Mi piace""Mi piace"

Vincenzo,

i risultati dipendono molto anche dalla stampante usata.

Per stampare una foto A3 (42×29,7 cm o 16,5×11,5 polliici) a 300 dpi (punti per pollice) occorrerebbero circa 18 Mpx, a 250 dpi circa 12. Anche con una stampante in grado di stampare a 300 dpi la differnza non sarebbe molto visibile se non con grande attenzione, e magari una lente, a causa dei limiti di risoluzione dell’occhio alla normale distanza di visione. Se poi la stampante non è di elevata qualità le differnze non si vedranno nemmeno stampando com meno dpi.

Riferendosi poi in particolare a fotocamere con sensore piccolo ed obiettivi superzoom ad ampia escursione, come la Fujifilm HS50EXR, il limite è la risoluzione degli obiettivi. Il sensore della HS50EXR da 16 Mpx (4608×3456 pixel) potrebbe risolvere circa 1600 linee in orizzontale (considerando il 70 % della risoluzione massima dovuto al degrado dell’intermpolazione Bayer), ma l’obiettivo arriva a questo valore solo alla focale minima ed al diaframma 4,0 (vedi prova), per il resto sta sulle 1000-1200 linee che corrisponderbbero a circa 4,5 Mpx reali interpolati (circa 8,5 Mpx prima dell’interpolazione), proprio quello che hai rilevato con le tue prove.

Ciao, Francesco

"Mi piace""Mi piace"

Cari Amici, non so come mai ricevo dei vostri messaggi, ad ogni modo dico la mia. Stampo spesso immagini in formato A3 con la mia Epson XP-950. Preparo lâimmagine con Photoshop CC, la riduco a 420 mm x 297 mm 240 ppi, ed essa è 30 Mpx. La risoluzione di 240 ppi è raccomandata da Scott Kelby, 300 ppi sono inutili. Saluti Mario

"Mi piace""Mi piace"